深度探索:机器学习中的Actor |

您所在的位置:网站首页 › music hall actors的中文 › 深度探索:机器学习中的Actor |

深度探索:机器学习中的Actor

|

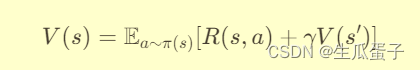

目录 1. 引言与背景 2. Bellman方程与动态规划 3. 算法原理 4. 算法实现 5. 优缺点分析 优点: 缺点: 6. 案例应用 7. 对比与其他算法 8. 结论与展望 1. 引言与背景在强化学习(Reinforcement Learning, RL)这一领域,智能体通过与环境的交互学习最优策略以最大化期望回报。其中,Actor-Critic算法凭借其独特的双引擎架构,巧妙地融合了策略学习(Actor)与价值函数估计(Critic),在理论完备性、算法稳定性与样本效率等方面展现出显著优势。本文将围绕Actor-Critic算法,详细阐述其背景、理论基础、算法原理、实现细节、优缺点分析、实际应用案例、与其他算法的对比,并展望其未来发展方向。 2. Bellman方程与动态规划Actor-Critic算法的理论基石是贝尔曼方程(Bellman Equation),它揭示了强化学习问题中的价值函数与策略之间的递归关系。贝尔曼期望方程(Bellman Expectation Equation)描述了状态价值函数V(s)的迭代更新过程:

其中, Actor-Critic算法的核心思想是将策略学习(Actor)与价值函数估计(Critic)分离为两个相互协作的组件: Actor(策略网络):负责生成智能体在各个状态下的动作选择策略。通过更新策略网络的参数,使其逐渐逼近最优策略,使得在给定状态下的动作选择能够最大化未来期望回报。 Critic(价值网络):负责评估Actor所选择策略的好坏,即估计状态价值函数或动作价值函数。Critic通过学习一个状态值函数V(s)或动作值函数Q(s, a),为Actor的更新提供指导信号,即策略梯度的方向。 Actor和Critic之间形成了一种闭环反馈机制:Critic基于观测到的经验评估当前策略的性能,提供策略梯度指引Actor更新;Actor在新的策略指导下与环境交互,产生新的经验数据供Critic进一步学习。这种协同工作模式有效地结合了基于值的强化学习方法的稳定性和基于策略的强化学习方法的灵活性。 4. 算法实现典型的Actor-Critic算法实现包括以下关键步骤: 网络结构:Actor网络通常采用前馈神经网络,输出层为动作空间的连续分布(如高斯分布)或离散分布(如Softmax分布)。Critic网络同样采用前馈神经网络,输出层为单个标量值,表示对当前状态价值的估计。 经验收集:智能体依据当前策略与环境交互,收集到一系列状态、动作、奖励、新状态和是否终止的信息,存储在经验回放缓冲区中。 更新循环: Critic更新:从回放缓冲区中采样一批经验,利用这些经验计算TD(Temporal Difference)误差或Advantage(A(s, a)),并据此更新Critic网络的参数,以减小价值估计与实际回报之间的差距。 Actor更新:基于Critic网络提供的状态值函数或动作值函数,计算策略梯度,并沿梯度方向更新Actor网络的参数,使策略趋向于选择具有更高期望回报的动作。 这里提供一个简化的Python代码示例来实现基于PyTorch的Actor-Critic算法。我们将以一个简单的连续动作空间环境为例,使用深度确定性策略梯度(Deep Deterministic Policy Gradients, DDPG)作为Actor-Critic的一个具体实例。DDPG是一种适用于连续动作空间的Actor-Critic算法,其中Actor网络输出的是动作的均值,而Critic网络则估计Q值。以下是代码实现及讲解: import torch import torch.nn as nn import torch.optim as optim from torch.distributions import Normal import gym # 定义环境 env = gym.make('Pendulum-v1') # 以Pendulum环境为例 # 定义超参数 BUFFER_SIZE = int(1e5) # 经验回放缓冲区大小 BATCH_SIZE = 64 # mini-batch大小 GAMMA = 0.99 # 折扣因子 TAU = 1e-3 # 软更新目标网络的系数 LR_ACTOR = 1e-3 # Actor网络学习率 LR_CRITIC = 1e-3 # Critic网络学习率 WEIGHT_DECAY = 0 # 权重衰减 UPDATE_EVERY = 2 # 每隔多少步更新一次网络 class ReplayBuffer: def __init__(self, buffer_size): self.buffer = deque(maxlen=buffer_size) def add(self, state, action, reward, next_state, done): self.buffer.append((state, action, reward, next_state, done)) def sample(self, batch_size): state, action, reward, next_state, done = zip(*random.sample(self.buffer, batch_size)) return torch.tensor(state), torch.tensor(action), torch.tensor(reward).unsqueeze(1), \ torch.tensor(next_state), torch.tensor(done).unsqueeze(1) class Actor(nn.Module): def __init__(self, state_dim, action_dim, hidden_dim=256): super().__init__() self.actor = nn.Sequential( nn.Linear(state_dim, hidden_dim), nn.ReLU(), nn.Linear(hidden_dim, hidden_dim), nn.ReLU(), nn.Linear(hidden_dim, action_dim), ) self.log_std = nn.Parameter(torch.zeros(1, action_dim)) def forward(self, state): mu = self.actor(state) std = torch.exp(self.log_std).expand_as(mu) dist = Normal(mu, std) return dist class Critic(nn.Module): def __init__(self, state_dim, action_dim, hidden_dim=256): super().__init__() self.critic = nn.Sequential( nn.Linear(state_dim + action_dim, hidden_dim), nn.ReLU(), nn.Linear(hidden_dim, hidden_dim), nn.ReLU(), nn.Linear(hidden_dim, 1), ) def forward(self, state, action): cat_input = torch.cat([state, action], dim=-1) return self.critic(cat_input) def compute_loss_critic(states, actions, rewards, next_states, dones, target_actor, target_critic, gamma=GAMMA): with torch.no_grad(): next_actions = target_actor(next_states) q_targets = rewards + gamma * (1 - dones) * target_critic(next_states, next_actions) current_q_values = critic(states, actions) critic_loss = F.mse_loss(current_q_values, q_targets) return critic_loss def compute_loss_actor(states, actor, critic): actions = actor(states) q_values = critic(states, actions) actor_loss = -q_values.mean() return actor_loss if __name__ == "__main__": # 初始化Actor、Critic、Target Actor、Target Critic网络 actor = Actor(env.observation_space.shape[0], env.action_space.shape[0]).to(device) critic = Critic(env.observation_space.shape[0], env.action_space.shape[0]).to(device) target_actor = copy.deepcopy(actor) target_critic = copy.deepcopy(critic) # 定义优化器 actor_optimizer = optim.Adam(actor.parameters(), lr=LR_ACTOR, weight_decay=WEIGHT_DECAY) critic_optimizer = optim.Adam(critic.parameters(), lr=LR_CRITIC, weight_decay=WEIGHT_DECAY) # 初始化经验回放缓冲区 replay_buffer = ReplayBuffer(BUFFER_SIZE) # 训练循环 for episode in range(NUM_EPISODES): state = env.reset() done = False episode_reward = 0 while not done: # 采样动作 action = actor(state).sample().cpu().numpy() # 执行动作并获取观测、奖励、是否结束 next_state, reward, done, _ = env.step(action) # 将经验存入回放缓冲区 replay_buffer.add(state, action, reward, next_state, done) # 更新网络 if len(replay_buffer) > BATCH_SIZE: states, actions, rewards, next_states, dones = replay_buffer.sample(BATCH_SIZE) critic_loss = compute_loss_critic(states, actions, rewards, next_states, dones, target_actor, target_critic) critic_optimizer.zero_grad() critic_loss.backward() critic_optimizer.step() actor_loss = compute_loss_actor(states, actor, critic) actor_optimizer.zero_grad() actor_loss.backward() actor_optimizer.step() # 软更新目标网络 update_target_networks(target_actor, actor, TAU) update_target_networks(target_critic, critic, TAU) state = next_state episode_reward += reward print(f"Episode {episode}: Reward: {episode_reward:.2f}")以上代码实现了DDPG算法的基本框架,包括: 定义环境:使用OpenAI Gym库创建一个环境实例,这里以Pendulum-v1为例。 定义超参数:设置经验回放缓冲区大小、批量更新大小、折扣因子、学习率、软更新系数等参数。 ReplayBuffer类:实现一个简单的经验回放缓冲区,用于存储和采样智能体与环境交互产生的经验。 Actor类:构建一个神经网络模型,其输入为状态,输出为动作分布(这里是正态分布的均值和对数标准差)。 Critic类:构建另一个神经网络模型,其输入为状态和动作,输出为对应的Q值。 损失函数计算:定义计算Critic网络损失(MSE损失)和Actor网络损失(负Q值均值)的函数。 主循环:在每个episode中,智能体与环境交互,将经验存储到回放缓冲区,当缓冲区足够大时,从中采样数据进行网络更新。同时,定期使用软更新策略更新目标网络。 请注意,这只是一个简化的示例,实际应用中可能需要添加更多功能,如噪声注入、动作截断、策略平滑等,以改善算法的性能和稳定性。此外,为了完整运行这段代码,您还需要安装所需的库(如gym、torch等),并在适当的位置导入缺失的模块和函数。 5. 优缺点分析 优点:理论完备:Actor-Critic算法基于强化学习的贝尔曼方程,具有坚实的理论基础。 稳定收敛:通过Critic网络提供稳定的价值估计,引导Actor网络的策略更新,有助于提高算法的收敛速度和稳定性。 高效利用经验:利用经验回放缓冲区进行经验重放,打破数据间的关联性,提升样本利用率,有利于在有限数据下学习良好策略。 缺点:计算复杂性:需要同时维护和更新两个神经网络,增加了计算负担。 超参数敏感:Actor学习率、Critic学习率、奖励折扣因子等超参数的选择对算法性能影响较大,需要精心调整。 收敛速度:尽管比纯策略或纯值函数方法更稳定,但在某些复杂任务中,Actor-Critic的收敛速度可能仍然较慢。 6. 案例应用游戏:在Atari游戏、Mujoco物理模拟环境中,Actor-Critic算法成功训练出能够完成复杂任务的智能体,如打乒乓球、走迷宫、操纵机械臂等。 机器人控制:在连续动作空间的机器人任务中,如无人机飞行控制、机械臂操作、移动机器人导航等,Actor-Critic算法展现出了强大的泛化能力和鲁棒性。 对话系统:在对话系统中,Actor-Critic算法被用于学习对话策略,使聊天机器人能够根据对话历史生成恰当且连贯的回复。 7. 对比与其他算法与DQN对比:DQN是一种基于值的强化学习算法,仅有一个网络(Critic)用于学习Q值函数。相比之下,Actor-Critic同时拥有Actor和Critic两个网络,能够直接学习策略,适用于连续动作空间任务,且通常具有更好的样本效率。 与Policy Gradient方法对比:如REINFORCE算法,仅包含Actor网络,通过采样得到的奖励直接更新策略。Actor-Critic在此基础上引入了Critic网络进行价值函数估计,提供了更稳定的梯度信号,有助于提高收敛速度和性能。 8. 结论与展望Actor-Critic算法作为强化学习领域的重要成果,以其独特的双引擎架构成功融合了策略学习与价值函数估计,展现了强大的泛化能力和稳健性。尽管存在计算复杂度高、超参数敏感等问题,但随着硬件算力的提升、算法优化技术的进步以及对强化学习理论理解的深化,Actor-Critic及其变种(如A2C、ACKTR、PPO等)将继续在游戏AI、机器人控制、对话系统等领域发挥重要作用。未来的研究方向可能包括但不限于:探索更高效的策略更新机制、开发适应大规模或高维任务的Actor-Critic变种、结合模仿学习与元学习提升学习效率,以及推进强化学习理论的进一步发展,以期在更广泛的现实世界问题中实现强化学习技术的有效应用。 |

【本文地址】

今日新闻 |

推荐新闻 |